Intel ofreció una actualización sobre las últimas previsiones de mercado de la compañía enfocado en su unidad de negocios de Data Center e Inteligencia Artificial, los planes de hardware y la forma en que está capacitando a los desarrolladores con software. Esto incluyó revelaciones sobre futuras generaciones de chips Intel Xeon, actualizaciones de progreso en procesadores escalables Intel Xeon de 4ª generación (nombre en código Sapphire Rapids) y demostraciones de hardware ante cargas de trabajo pesadas de IA y más.

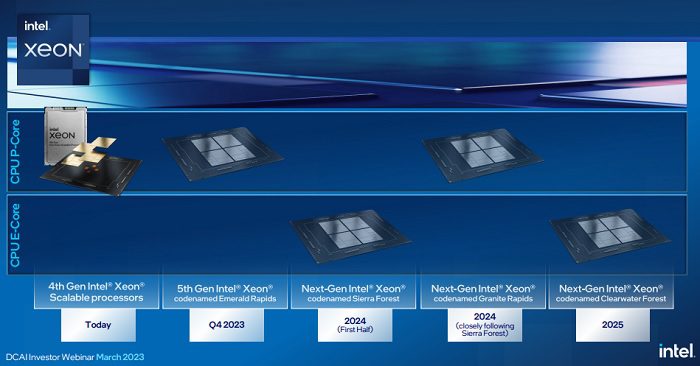

Pase de lista de la hoja de ruta de Xeon

Intel anunció una actualización de 4ª generación de Intel Xeon escalable (Sapphire Rapids). Todos los principales fabricantes de equipos originales (OEM) y fabricantes de diseño original (ODM) están enviando sistemas Xeon de 4ª generación, y los 10 principales proveedores mundiales de servicios en la nube están trabajando en la implementación de servicios en Xeon de 4ª generación. Se trata de la CPU de centro de datos de más alta calidad de Intel.

Además, llega la 5ta. generación de Intel Xeon escalable (nombre en código Emerald Rapids). Se trata del próximo producto Performance-core (P-core) de Intel.

En el primer semestre 2024 llegará Sierra Forest, el procesador Efficiency-core (E-core), contará con 144 núcleos por socket. La primera CPU basada en el próximo proceso Intel 3, Sierra Forest se encendió a principios de este trimestre con múltiples sistemas operativos arrancando en un tiempo récord (menos de un día).

El cuarto anunció de esta gama fue Granite Rapids llegará poco después de Sierra Forest en 2024. Aunque aún no se ha revelado una fecha de lanzamiento específica, su tiempo de comercialización se beneficiará de compartir una plataforma con Sierra Forest.

Por último, Intel continuará ejecutando su hoja de ruta E-core con la continuación de Sierra Forest: Clearwater Forest. Llegando al mercado en 2025, Clearwater Forest se fabricará en Intel 18A, el nodo donde Intel planea lograr el liderazgo en procesos: es la culminación de la estrategia de cinco nodos en cuatro años de la compañía.

Bits de bonificación

- El acelerador de AI Habana Gaudí 3 se ha grabado. Los detalles de rendimiento aún no se han compartido, pero Habana Gaudí 2 está en el entorno y ofrece una ventaja de 1.8x en rendimiento por vatio sobre un servidor A100 comparable cuando se ejecuta una carga de trabajo de visión artificial popular.

- Hay 15 nuevos productos FPGA programados para pasar por el proceso de calificación de lanzamiento de producción (PRQ) este año, es decir, más presentaciones de productos nuevos que nunca antes en el negocio de FPGA de Intel.

La AI está en todas partes y es para todos

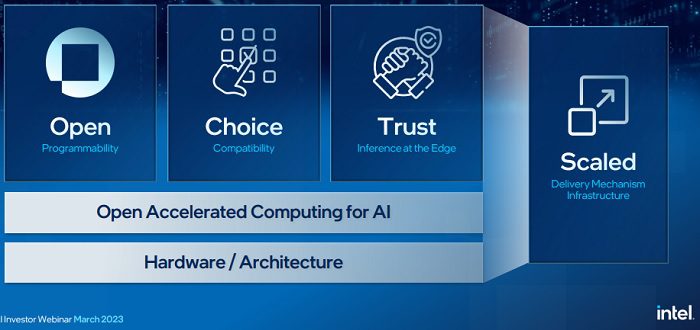

Dejando a un lado las actualizaciones de silicio, la IA también es un tema persistente para Intel, tanto en hardware de IA, desde la preparación y administración de datos hasta la capacitación e inferencia a pequeña y mediana escala en Xeon, y el entrenamiento e inferencia de modelos cada vez más grandes utilizando GPU y aceleradores Intel.

Intel se suma al compromiso de democratizar la IA desde la nube hasta la red y hasta el borde al permitir un acceso más amplio a las soluciones y despliegues más rentables a través de un enfoque de ecosistema abierto. A medida que aumentan las cargas de trabajo de IA, implementarlas a escala requerirá un software que facilite a los desarrolladores programar y que florezca un ecosistema vibrante, abierto y seguro.

Por ello, están desarrollando una alternativa abierta y multiarquitectura disponible para múltiples proveedores, un lenguaje de programación estandarizado al que todos puedan contribuir, colaborar, no esté encerrado en un proveedor en particular y pueda evolucionar orgánicamente en función de sus miembros y requisitos públicos.

Intel ha hecho contribuciones a SYCL, un modelo de programación abierto basado en C ++, y adquirió Codeplay Software (líder en el lenguaje y la comunidad SYCL). SYCL ahora se incluye en oneAPI para que los clientes puedan programar y compilar a través de CPU, GPU y aceleradores de múltiples proveedores. El trabajo adicional en optimizaciones de software ascendentes incluye optimizaciones para PyTorch 2.0 y TensorFlow 2.9, así como una colaboración con Hugging Face para entrenar, ajustar y predecir con la ayuda de Intel Xeon y Gaudi 2.

Impulsar el progreso en la IA generativa

La filosofía abierta de Intel se extiende al campo de la IA generativa, donde herramientas como ChatGPT y el modelo de texto a imagen DALL· E 2 está aprovechando los algoritmos de IA y los grandes conjuntos de datos para producir nuevo contenido basado en indicaciones humanas cada vez más complejas.

La IA generativa está evolucionando a gran velocidad (parece que hay titulares casi diarios sobre avances), e Intel está trabajando activamente para apoyar un ecosistema de IA generativa abierta al tiempo que aborda las crecientes demandas de rendimiento.

A principios de esta semana, Hugging Face, un jugador importante en el desarrollo de aplicaciones de aprendizaje automático, anunció que había habilitado el modelo BLOOMZ de 176 mil millones de parámetros en Gaudí 2 de Habana. El modelo BLOOM es un modelo de IA de lenguaje grande de código abierto análogo al modelo GPT-3 del parámetro 175B empleado por ChatGPT. La compañía también confirmó que está ejecutando el modelo de texto a imagen de aprendizaje profundo Stable Diffusion en Xeon de 4ª generación con Intel AMX incorporado para la aceleración de la carga de trabajo de IA (Stable Diffusion es una alternativa de acceso abierto a DALL· E).

Más allá de los esfuerzos de Intel para reforzar un ecosistema abierto y ético, Xeon también está presente y se tiene en cuenta en otras partes del panorama de la IA generativa.