Microsoft anunció dos nuevas tecnologías para combatir la desinformación, nuevos trabajos para ayudar a educar al público sobre el problema, y asociaciones para ayudar a avanzar en estas tecnologías y esfuerzos educativos de manera rápida.

En una investigación apoyada por Microsoft, el profesor Jacob Shapiro en Princeton, actualizada en agosto de 2020, catalogó 96 campañas separadas de influencia extranjera dirigidas a 30 países, entre 2013 y 2019. Estas campañas, realizadas a través de redes sociales, buscaban difamar a personas notables, persuadir al público o polarizar debates. Mientras que el 26% de estas campañas fueron dirigidas a Estados Unidos, otros países que fueron objetivo incluyeron a Alemania, Arabia Saudita, Armenia, Australia, Brasil, Canadá, Francia, Holanda, Polonia, Reino Unido, Sudáfrica, Taiwán, Ucrania y Yemen. Alrededor del 93% de estas campañas incluyeron la creación de contenido original, 86% amplificaron contenido preexistente, y 74% distorsionaron hechos verificables de manera objetiva.

Reportes recientes también muestran que la desinformación ha sido distribuida alrededor de la pandemia de COVID-19, lo que ha llevado a muertes y hospitalizaciones de personas que buscaban supuestas curas que en realidad son peligrosas.

Microsoft ha trabajado en dos diferentes tecnologías para hacer frente a los diferentes aspectos del problema que representa la desinformación.

Uno de los grandes problema de ésto son los deepfakes, o medios sintéticos, que son fotos, videos o archivos de audio manipulados por inteligencia artificial (IA) en formas que son difíciles de detectar. Pueden aparecer para hacer que la gente diga cosas que no dijo o estar en lugares donde no estuvo, y el hecho de que están generadas por IA, que puede continuar aprendiendo, hace inevitable que puedan vencer a la tecnología convencional de detección. Sin embargo, a corto plazo, como las próximas elecciones en Estados Unidos, las tecnologías avanzadas de detección pueden ser una útil herramienta para ayudar a los usuarios más exigentes a identificar deepfakes.

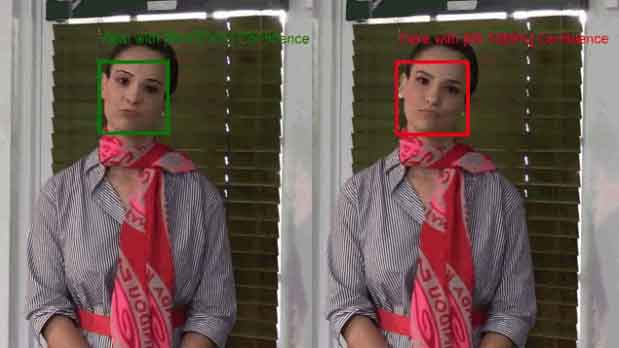

Microsoft anunció Microsoft Video Authenticator, que puede analizar una foto fija o un video para brindar un porcentaje de probabilidad, o una calificación de confianza, de que el medio haya sido manipulado de manera artificial. En el caso de un video, puede brindar este porcentaje en tiempo real sobre cada cuadro a medida que se reproduce el video. Funciona a través de detectar el límite de fusión del deepfake y el sutil desvanecimiento o elementos de escala de grises que tal vez no puedan ser detectados por el ojo humano.

En un principio, esta tecnología fue desarrollada por Microsoft Research, en coordinación con el equipo de Responsible AI de Microsoft, y el Comité de IA, ética y efectos en ingeniería e investigación (AETHER) de Microsoft, que es un consejo asesor en Microsoft que ayuda a asegurar que la nueva tecnología sea desarrollada e integrada de manera responsable. Video Authenticator fue creado a través de una base de datos pública de Face Forensic+ y fue probada en el DeepFake Detection Challenge Dataset.

Asimismo, también se anunció una nueva tecnología que puede detectar contenido manipulado y asegurar a la gente que los medios que ven son auténticos. Esta tecnología tiene dos componentes. El primero es una herramienta integrada en Microsoft Azure, que permite a un productor de contenido agregar hashes y certificados a una pieza de contenido, que luego viven en él como metadatos, donde sea que viajen en línea. El segundo es un lector, que puede existir como una extensión de navegador o en otras formas, que comprueba los certificados y relaciona los hashes, para permitir a la gente saber, con alto grado de precisión, que el contenido es auténtico y que no ha sido cambiado, así como brindar detalles sobre quién lo produjo.

Esta tecnología ha sido construida por Microsoft Research y Microsoft Azure, en asociación con el Programa Defending Democracy, y va a impulsar una iniciativa recién anunciada por la BBC, llamada Project Origin.

Por último, en meses recientes se expandió la implementación de NewsGuard, que permite a las personas aprender más sobre una fuente de noticias en línea antes de consumir su contenido, combatiendo el compartir contenido con desinformación.